BNN 的定义

贝叶斯神经网络(Bayesian neural networks, BNNs):

- 神经网络中的可训练参数,即权重(weight)和偏置(bias)都表示为一个分布

- 一种最简单的 BNN 就是将模型参数看作服从均值为 $\mu$,方差为 $\delta$ 的高斯分布;考虑到中心极限定理的存在,一般认为模型参数符合高斯分布是一种合理的假设

- 在预测时,BNN 会从每个高斯分布采样,得到一个确定的神经网络,然后用于预测;也可以对参数多次采样后分别进行预测,然后将多次预测结果进行汇总(类

分类目录归档:DeepLearning

贝叶斯神经网络(Bayesian neural networks, BNNs):

方案:将 config.json 文件中 num_hidden_layers 的值修改为较小的值(比如 1)

原理:隐藏层中 block 的输入输出维度是一致的,因此去除重复的 block 并不会影响模型的处理逻辑;但需要注意该方法会影响模型的性能,因此只适合模型调试阶段使用。

分层推理法:将模型根据层来进行拆分存储,推理时分批次将要处理的层导入显存

代码示例:

from accelerate import init_empty_weights

from accele模型融合(model merging):

思考:如何验证模型融合的合理性? (此处

循环神经网络(RNNs):具有隐状态、不同层参数共享的神经网络

常见的三种基础 RNNs :RNN、GRU、LSTM

隐变量模型:使用隐状态 $h_{t-1}$ 存储前 $t-1$ 步的序列信息 $$P(x_t|x_{t-1},...,x_1)\approx P(x_t|h_{t-1})$$ $$h_t=f(x_t,h_{t-1})$$ 循环神经网络(recurrent neural networks,RNNs) 是具有隐状态的神经网络

假设时刻 $t$ 的输入为 $X_t \in \mathbb{R}^{n\times d}$,对应的权重参数为 $W

卷积神经网络(CNN):引入了卷积操作的神经网络

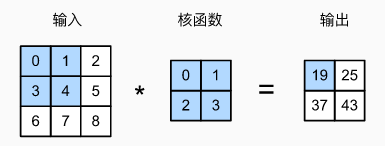

严格来说,卷积层是个错误的叫法,因为它所表达的运算其实是互相关运算(cross-correlation)

二维互相关运算示例:

池化(pool)层的优点:降低卷积层对位置的敏感性

常用池化层分两种:最大池化层和平均池化层,前者示例如下:

类似于卷积层,池化层也会有填充和步幅,使用大于 1 的步幅可以起到降维的作用

不同于卷积层,池化层在每个输入通道上是单独计算的,所以池化层的输出通道数等于输入通道数

膨胀(dilated)卷积,也称

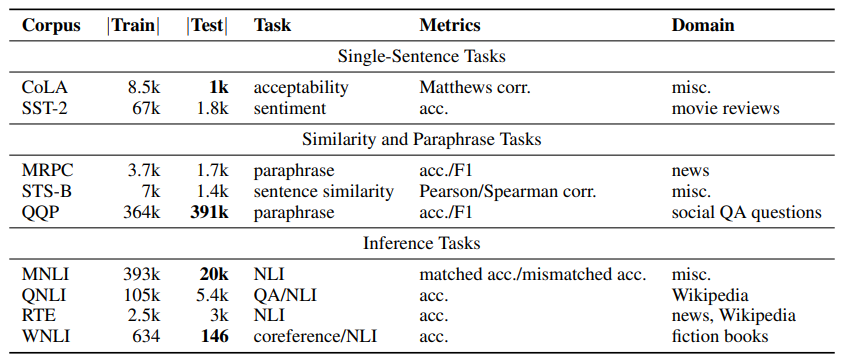

GLUE(General Language Understanding Evaluation,通用语言理解评估)是一种常用的评估工具,用于评估 NLP 模型在一系列任务上的有效性。

GLUE 基准测试由纽约大学和谷歌的研究人员开发的。开发 GLUE 的动机是需要一个全面的 NLP 模型评估框架,该框架测试语言理解的不同方面并提供更完整的描述

官网为: https://gluebenchmark.com/

GLUE 共包含 3 个分类 9 个任务:

随着 AI 模型的能力提升,人类需要一些更有趣的测试集来刁难他们~

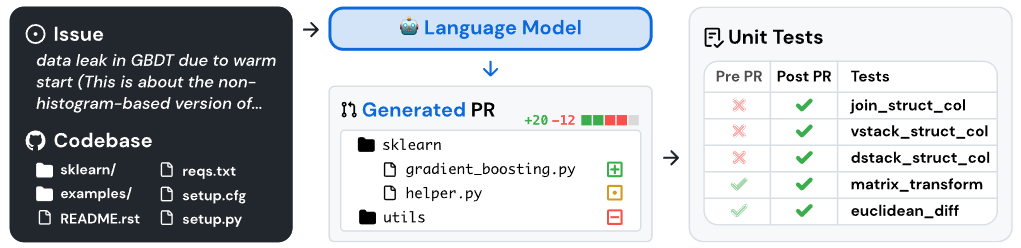

SWE-bench 是一个在现实软件工程(GitHub)环境中评估 LMs 的基准

SWE-ben

SWE-ben