1 基本信息

机器学习始于计算机科学的人工智能领域,后来也有不少统计学家加入。如果说哪位统计学家对机器学习的贡献最大,里奥·布莱曼(Leo Breiman)或许当之无愧。

(January 27, 1928 – July 5, 2005)

(January 27, 1928 – July 5, 2005)

2 个人经历

2.1 贫民窟

1928年1月27日,Leo Breiman 出生于纽约,五年后随父母移居旧金山,初中时再次搬家到洛杉矶。Breiman 所在的社区 Boyle Heights,是当时洛杉矶的犹太贫民窟(a poor Jewish ghetto),与边上的墨西哥裔贫民窟相邻。

尽管 Breiman 就学的罗斯福高中(Roosevelt High School)位于当时洛杉矶的贫民区,但在学术上依然领先,因为该校的大多数学生都是追求上进的移民后代(highly motivated sons and daughters of immigrants)。

在高中时代,首先让 Breiman 感兴趣的课程是几何学。他母亲偶然听说,加州理工学院(Caltech)是美国西部最好的大学,于是决定她的儿子应该去Caltech 读大学(这也是钱学森的母校)。

2.2 加州理工学院

1945年,经过长达16小时的入学考试后,Breiman 成功进入加州理工学院,主修物理,并因成绩优异而获得奖学金。然而,到了大学高年级,由于在校园里到处充斥着理工知识而渐生厌倦,感觉 Caltech 就像一个“科学修道院”(scientific monastery)。终于,他在大学最后一年的四门物理课中都得了 “D”。如果在这个时点,用机器学习的方法预测年轻 Breiman 的未来,应该也不会太辉煌吧?

2.3 哥伦比亚大学

然而,Breiman 依然对数学很有兴趣,于是开始向许多大学申请读研究生,但仅被哥伦比亚大学(Columbia University)录取。由于家境贫寒,Breiman利用兼职打工攒下的钱,供自己读研。事实上,刚到哥大时,Breiman 曾决心读哲学专业,并找到了哥大哲学系主任,当时的知名哲学家Erwin Edwin。Erwin Edwin 和蔼地拍了拍 Breiman 的膝盖说,“我最好的两位博士生现在都无法找到工作。要不你还是待在数学系,可以先上几门哲学课,看情况再说吧”。之后,Breiman 上了几门哲学课,诸如美学、希腊哲学,发现与自己的预想大相径庭。于是,Breiman 开始专攻数学,并在一年内拿到了数学硕士学位。

2.4 加州大学伯克利分校

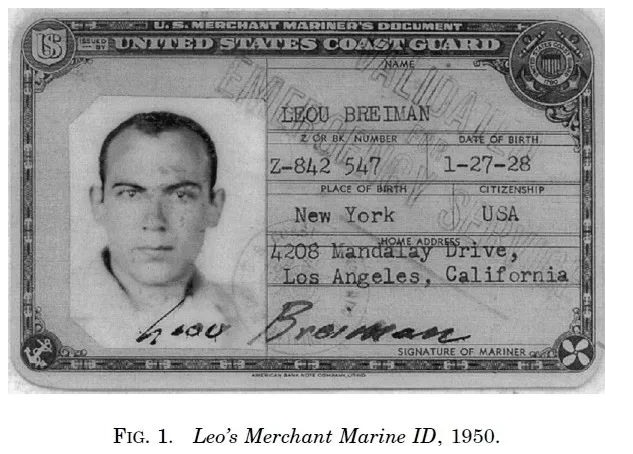

1950年,Breiman 从哥大毕业后,进入加州大学伯克利分校攻读数学博士学位。为了供自己上学,Breiman入学前的整个暑期都在当酒店招待,以及在海岸警卫队(Coast Guard)的舰船上洗碗(下图为当时的工作证)。

在伯克利,Breiman 选修了著名概率学家 Michel Loeve 的概率论课程(知名同班同学包括 Manny Parzen,Howard Tucker 等),并爱上了概率论。Breiman 完成博士论文之后,自我感觉良好,但完美主义的导师 Michel Loeve 却依然不满意;直至著名统计学家 Harald Cramer 来访,听了Breiman 的报告后认为 “this is pretty good”。最后,在限期参军的压力下,Michel Loeve 终于让 Breiman 于 1954 年博士毕业。

在伯克利,Breiman 选修了著名概率学家 Michel Loeve 的概率论课程(知名同班同学包括 Manny Parzen,Howard Tucker 等),并爱上了概率论。Breiman 完成博士论文之后,自我感觉良好,但完美主义的导师 Michel Loeve 却依然不满意;直至著名统计学家 Harald Cramer 来访,听了Breiman 的报告后认为 “this is pretty good”。最后,在限期参军的压力下,Michel Loeve 终于让 Breiman 于 1954 年博士毕业。

博士毕业后,Breiman 服了两年兵役。之后,Breiman 成为伯克利的 “代理助理教授”(acting assistant professor),并与伯克利的著名统计学家 David Blackwell相熟。在伯克利的学术讲座中,Blackwell 经常写条子给Breiman,“你能证明这个与这个吗?” 这其中的一个纸条,使得 Breiman 证明了后来被称为“Shannon-Breiman-McMillan Theorem”的定理(Breiman, 1957)。

2.5 加州大学洛杉矶分校

当时伯克利有严格的规定,刚从伯克利毕业的博士生无法在伯克利得到第一份正式工作。退而求其次,Breiman 成为加州大学洛杉矶分校(UCLA)的助理教授,为当时 UCLA 数学系唯一的概率论学者。

Breiman 在 UCLA 执教了七年,期间很快拿到了终身教职。然而,他最后决定自己并不想做一名 “抽象的数学家”(abstract mathematician),于是从UCLA 辞职。之后,Breiman 花了半年时间,专心总结他对于概率论的心得与教学经验,于1968年出版其第一本著作 “Probability”,成为概率论的经典书籍。

2.6 统计咨询工作

从UCLA辞职后,当 Breiman 的积蓄快要花光时,他开始Technology Service Corporation(TSC)从事 “统计咨询”(statistical consulting)工作。离开了抽象的概率论,Breiman 开始接触到大量的鲜活数据;比如,与空气污染有关的几百个变量,每天或每小时的数据,跨度达到七年。研究问题包括预测洛杉矶盆地(Los Angeles Basin)第二天的臭氧水平,预测高速公路的一氧化碳水平等回归问题(regression)。当然,也有一些分类问题(classification),比如根据雷达声呐数据来区分俄国与美国的潜艇。在此期间,Breiman 开始使用并完善 “决策树”(decision tree)模型进行预测。与通常的线性回归或逻辑回归不同,决策树模型是一种非参数方法,并不设定具体的函数形式,故在进行预测时更为灵活。

2.7 重回加州大学伯克利分校

Breiman 从事了 13 年的统计咨询工作,一直很享受,本不想再回学术界。然而,当母校召唤时,Breiman 于 1980 年重回伯克利,成为统计系教授。此时,伯克利统计系依然处于纸与笔的时代,计算机设备十分原始。在 Breiman的倡导与努力下,伯克利统计系终于有了现代的统计计算中心(Statistical Computing Facility)。

1984年,Breiman与三位合作者共同出版了决策树的经典书籍 “Classification and Regression Trees”,提出了著名的 CART 算法。

2.8 退休生涯

1993年,Breiman 从伯克利退休。但或许谁也没有想到,Breiman 学术生涯的高潮才刚刚开始。在研究中,Breiman 发现,使用线性模型选择变量的子集(subset selection in linear regression)是一个很不稳定的过程;只要数据稍微变化,所选变量就可能很不相同。对于决策树也如此,只要数据稍有变化,所生成的决策树可能就大相径庭。

于是,Breiman 想,能否将这些不同的模型结果进行平均,以得到更好的预测效果。但如何扰动数据呢?Breiman想到了有放回的自助抽样(bootstrap)。首先,从原始样本得到大量的自助样本(bootstrap sample),分别用 CART 算法来估计决策树,然后再将这些决策树进行聚合平均(比如,平均1000棵决策树)。这就是Breiman (1996)提出的 “bagging” 算法(bootstrap aggregating),该文目前在 Google Scholar的引用量已超过 2 万。

2001年,Breiman 进一步提出了 “随机森林”(Random Forest)的算法。与Bagging 不同,在决策树的每个节点,仅随机选取部分变量进行分裂,以降低不同决策树之间的相关性。结果发现,Random Forest的预测效果比 Bagging 又有了进一步的提高,这使得随机森林成为机器学习,特别是数据科学的主要算法之一。2005年,Breiman 在伯克利家中去世,享年 77 岁。

3 主要成就

Breiman的工作帮助弥合了统计学和计算机科学之间的鸿沟,尤其是在机器学习领域。他最重要的贡献是在分类和回归树领域,通过借助集成树拟合自助抽样样本,也就是著名的bagging算法。而他的另一个著名集成算法就是随机森林

4 个人点评

早期机器学习集成算法的奠基人 膜拜~