前置知识:双重差分法 DID、合成控制法、双向固定效应 TWFE

前置算法回顾

已知双重差分法 DID 的线性模型可表示如下: $$ Y_{it} = \beta_0 + \beta_1 Post_t + \beta_2 Treated_i + \beta_3 Treated_i Post_t + e_{it} $$

- 其中

post表示时间虚拟变量,treated表示干预虚拟变量

而通过引入个体/时间的固定效应,可以将 DID 表示为 TWFE 的形式: $$ \hat{\tau}^{did} = \underset{\mu, \alpha, \

前置知识:因果推断入门

随机实验(Randomised Experiments)

- 将总体中的个体随机分配到实验组或对照组

- 随机化通过使潜在结果与治疗无关来消除偏差:$(Y_0, Y_1) \perp!!!\perp T$

- 因此随机实验可以直接得到平均因果效应 $ATE$ $$

ATE=E[Y|T=1] - E[Y|T=0] = E[Y_1 - Y_0] $$

常见的随机实验:

- 随机对照试验(RCT)是获得因果效应最可靠的方法,简单直接且极具说服力

- 在线对照实验(A/B Test)常用于

去年总结: 2024年Obsidian新玩法总结

版本更新

- V1.8(20250130):支持 Obsidian 内部浏览网页的 Web Viewer 核心插件;新增“Download attachments for current file”命令,可下载所有外部嵌入的图片,并将外部链接替换为内部嵌入;脚注自动补全

- 20250221:官方宣布免费支持商业用途,无须担心商业许可问题

- V1.9(20250521):引入 bases 核心插件,用于笔记的数据库管理;支持侧边栏管理脚注;引入属性值为列表(以前是文本)的 tags 、 aliases

前置知识:因果效应评估_准实验、因果效应评估_异质性 、双重机器学习 DML

双向固定效应

双向固定效应(Two Way Fixed Effect,TWFE)

- 作为双重差分法 DID 的一种常见回归模型实现方式

- TWFE 假设干扰效应是常量,并引入个体/时间的固定效应

- 对于不同组的干预时间相同的情况,TWFE 和 DID 是等价的

当出现不同组的干预时间不同的情况,即错位实施(Staggered Adoption),TWFE 对干预效应的评估容易存在偏差,尤其是干预效应存在时间异质性的情况

简单来说,TWFE 会将早期干预组的干预效应

前置知识:因果效应评估_配平法、因果效应评估_异质性 、因果效应评估_元学习

双重机器学习

双重机器学习 (Double Machine Learning, DML):利用机器学习强大的预测能力,先剔除 X 对 T 的影响,再剔除 X 对 Y 的影响,最后看残差之间的关系。

DML 的实现过程:

- 先构建回归模型 $M_{y}$,该模型能根据特征 $X$ 来估计结果 $Y$

- 再构建回归模型 $M_{t}$,该模型能根据特征 $X$ 来估计干预 $T$

- 计算两个模型的残差:$\tilde{Y} = Y - M_y(X)$,$\tilde{T}

SOAP (Subjective, Objective, Assessment and Plan)记录

- 一种医疗保健从业者广泛使用的结构化记录方法

- SOAP 格式是临床评估信息的提供框架,有助于快速了解患者情况,方便医护人员之间的沟通;也是临床推理的认知框架,有助于指导医护人员根据患者提供的信息来评估、诊断和治疗患者

- SOAP 格式的医疗记录包含主观、客观、评估和计划四个部分

- SOAP 的目的在于整合组织病历中最具临床意义的数据,方便医生理解和使用

主观描述(Subjective):患者或其亲属的“主观”经历、个人观点或感受

- 主诉(Chief Complaint,CC),就诊原因,是

元学习

- 一种因果效应评估的学习范式,属于潜在结果框架

- 需要根据实际的业务场景来选择不同类型的元学习方法

- 元学习的效果也高度依赖所选择和组合的机器学习方法

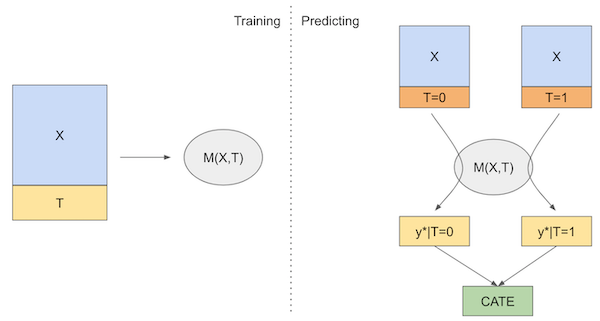

S-Learner

S 学习器(S-Learner)是一种最简单的元学习方法

- 先训练模型 $M_{s}$ 来根据外生变量 $X$ 和干预变量 $T$ 来预测结果

- 之后在推理阶段,通过指定不同的干预变量取值,来推理结果

- 最后两种推理结果的差值即为条件干预效应(CATE)的估计值:

$$ \hat{\tau}(