作者文章归档:王半仙

发表评论

1221 views

发表评论

95 views

倒数排名融合(Reciprocal Rank Fusion,RRF)

- 一种简单有效的多检索结果聚合方法,效果始终优于单一系统

- RRF 常用于混合检索的场景,比如关键词检索和向量检索的混合

RRF 的核心公式: $$ RRFscore(d\in D) = \Sigma_{r\in R}\frac{1}{k+r(d)} $$

- 其中 $D$ 表示文档集合,$R$ 是不同检索后的文档排序结果

- $k$ 是常量,默认为 60;用于减轻异常检索结果中的高排名影响

RRF 的简单示例:

- 假设文档

docA在三次不同的检索策略中出现,检索排名分别 1、2、1 - 则文档

docA的最终 RRF 得

发表评论

1091 views

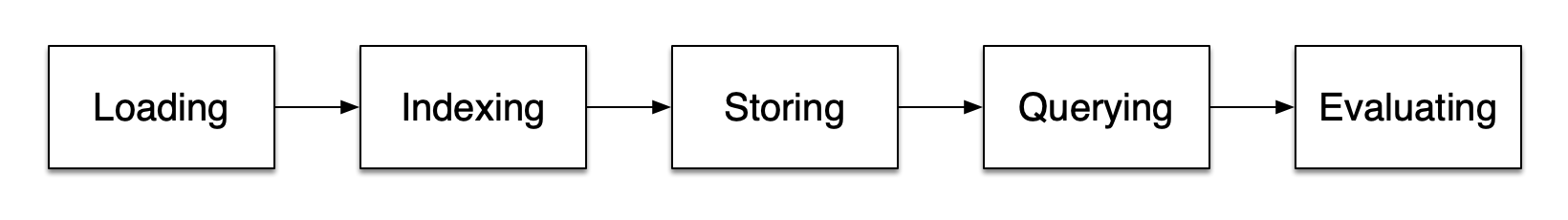

前置知识:检索增强 RAG,

相比于朴素 RAG,高级 RAG 在预检索过程(Pre-Retrieval Process) 和 后检索过程(Post-Retrieval Process) 两个阶段引入了一些改进措施,提高检索质量

- 预检索过程的重点是索引优化与查询优化;前者目的是提高被索引内容的质量,包括检索粒度、索引结构优化、元数据附加、对齐优化和混合检索等操作;后者目的是优化用户的原始问题表述,比如查询重写、查询转换和查询扩展等技术

- 后检索过程的重点是相关上下文的有效整合;比如重排序,将最相关的信息排在考前的位置;或者上下文压缩,

发表评论

1775 views

整体 NAS 规划:

- 准主机说明:天钡WTR Pro 5825U + 自行购买的内存、SSD 和磁盘

- 系统以 PVE 为底层,确保稳定性,并配置 fnOS 等虚拟机

- 短期目标:搭建家庭影院和相册,实现重要数据的多源备份

1 虚拟机系统 PVE

PVE 是在 Linux/Debian 基础上深度定制化的底层虚拟机系统

- 优点:开源易用,性能出色

- 缺点:安装略有些繁琐

一、准备工作:

发表评论

989 views

前置知识:检索增强 RAG

1 内容缺失

问题现象:知识库中缺少上下文,导致 RAG 给出一个看似合理但错误的答案

解决方案:

- Garbage in, garbage out;清理不合理的数据,避免重复或无关信息

- 通过 Prompt 鼓励鼓励模型承认其局限性,并更透明地表达不确定性

2 排序遗漏

问题现象:不合理的检索排序导致关键文档被遗漏,没有被正确返回给 LLM

解决方案:

- 调整数据检索相关的超参

发表评论

1084 views

发表评论

919 views

发表评论

1235 views

前置知识:强化学习入门、Q-Learning

Dyna 框架

Dyna 是一种经典的强化学习算法

- Dyna 会尝试从环境中学习两个独立模型(1)状态转移模型 $P$,根据当前状态 $s$ 和动作 $a$,预测下一个的状态 $s'$(2)奖励预测模型 $R$,根据当前状态 $s$ 和动作 $a$,预测环境的反馈奖励 $r$

- Dyna 作为一类算法的总称,可以将基于模型的强化学习与无模型的强化学习进行组合,从而使得策略/价值函数既可以从环境模型中学习,也可以在与真实环境交互中学习,结合二者的优势

- Dyna 的环境模型一般为查表法或监督学习的预测

发表评论

977 views

前置知识:强化学习入门、Deep Q-Learning、策略梯度算法

Actor-Critic

Actor-Critic (简称 AC)是一种经典的强化学习框架

- 结合了策略(Policy Based)和价值(Value Based)

- Actor 表示策略函数,负责动作生成与环境交互

- Critic 表示价值函数,负责 Actor 的表现评估和指导

AC 算法的 Actor 策略函数近似 $$ \pi_{\theta}(s,a) = P(a|s,\theta)\approx \pi(a|s) $$

- Actor 的定义与策略

发表评论

1123 views